Aujourd'hui, la collaboration LHCb a présenté un rapport de conception technique pour un nouveau système de déclenchement de premier niveau basé sur des processeurs graphiques (GPU) au Comité des expériences du LHC du CERN (LHCC), et a annoncé sa décision d'utiliser ce système comme sa nouvelle base de référence pendant le Run 3 du LHC, qui devra commencer 2021 si COVID le permet. Ce nouveau système, nommé "Allen" d'après la pionnière de l'informatique Frances E. Allen, sera le premier système de déclenchement haut débit complètement basé sur GPU déployé dans une expérience de physique des hautes énergies (HEP), capable de traiter le taux de collisions du LHC de 40 MHz et réduisant leur taux d’un facteur 30 à 60. L'équipe RECEPT a joué un rôle clef dans la proposition, la conception et l’aboutissement d’Allen, Dorothea codirigeant le développement et Renato et Florian apportant des contributions cruciales à la reconstruction de particules chargées et recherche de collision protons-protons, respectivement. Alors, comment est-ce arrivé?

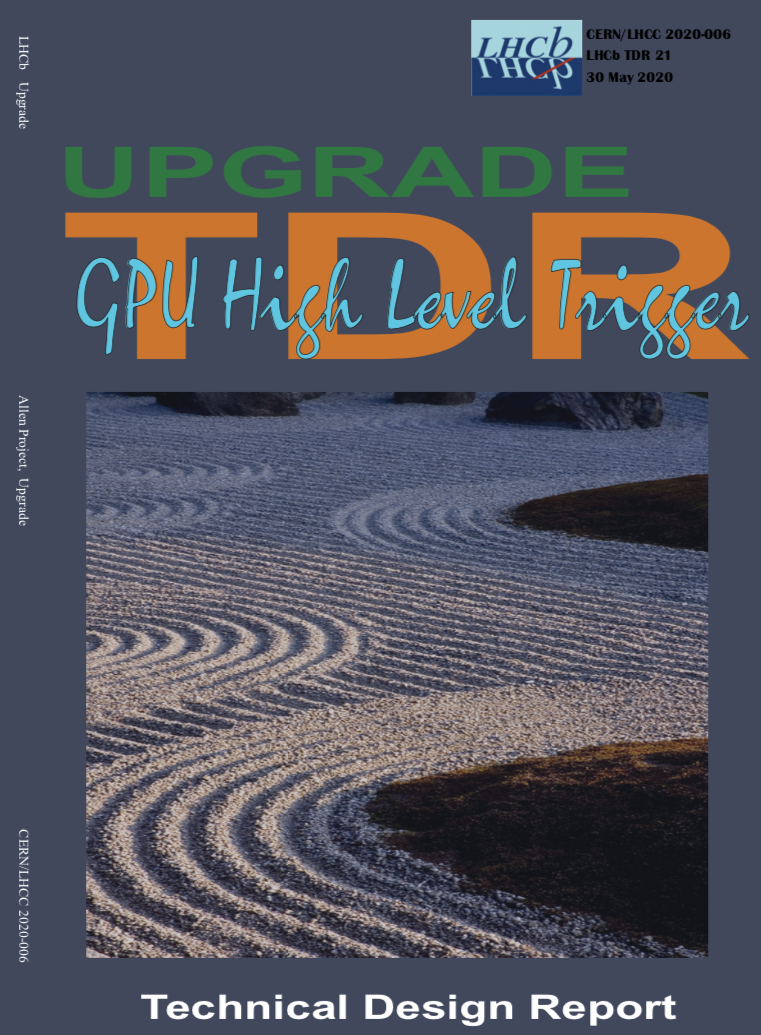

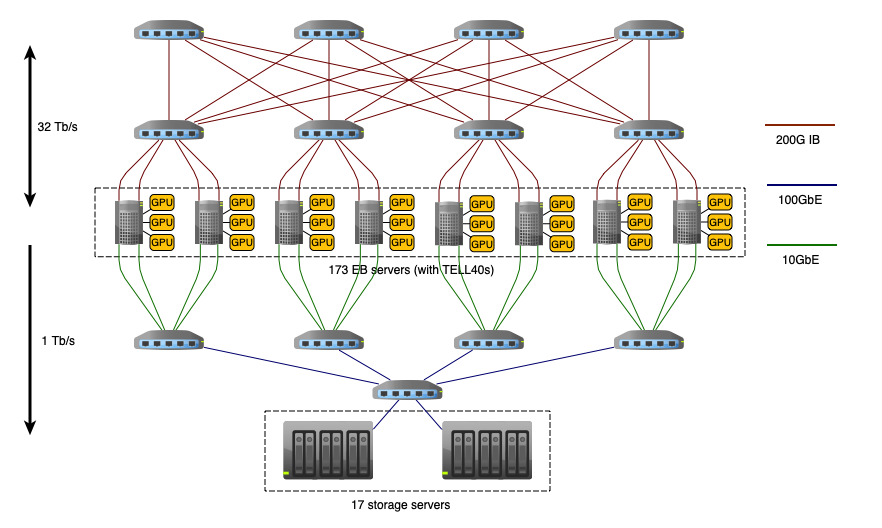

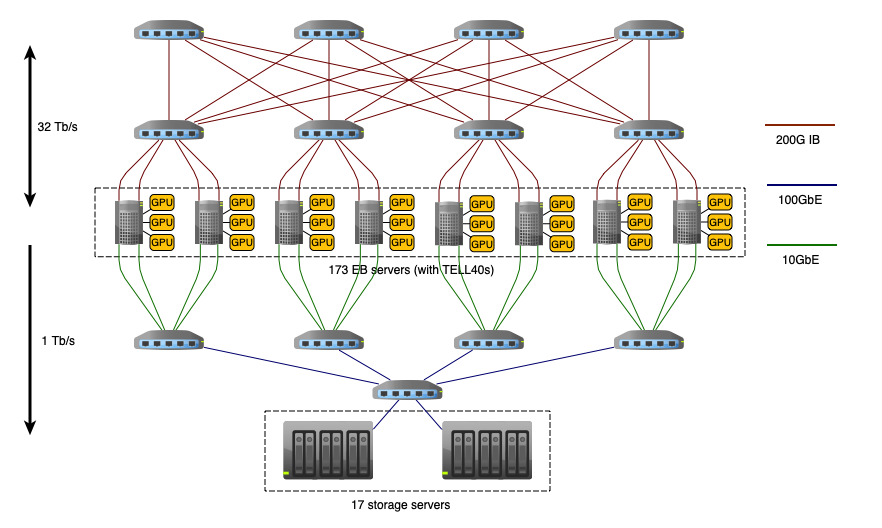

L'expérience LHCb améliorée (upgrade), qui doit commencer à prendre des données en 2021, doit traiter 5 To de données par seconde et sélectionner la plus intéressante 10 gigaoctets pour le stockage permanent et l'analyse physique, éliminant définitivement le reste dans un système de traitement en temps réel appelé système de déclenchement. Au cœur de la proposition Allen était la prise de conscience que les GPU modernes étaient devenus suffisamment puissants pour que le système de déclenchement de premier niveau de LHCb pourrait être implémenté avec environ 500 de ces cartes GPU. Cette implémentation compacte, illustrée ci-dessous, permet de déployer le système de déclenchement de premier niveau directement dans les serveurs "EB" qui reçoivent les données du détecteur. Ces serveurs hébergeraient normalement des cartes réseau dédiées à large bande passante pour envoyer les données du détecteur vers le traitement, mais comme Allen peut traiter les données en place, les GPU peut remplacer ces cartes réseau. Cela signifie qu'il n'y a pas de frais généraux associés au déploiement des GPU, et au contraire ils économisent l'argent qui aurait été dépensé sur les cartes réseau. Selon le marché, le coût global du système peut être nul, voire négatif.

Allen n'était bien sûr pas développé ex nihilo: de nombreux groupes LHCb ont mené des recherches sur la faisabilité des algorithmes de traitement GPU depuis environ 2013. Mais au moment où Allen a été proposé en février 2018, la seule partie du système de déclenchement de premier niveau qui existait sur les GPU était la reconstruction du détecteur de vertex du LHCb. Et même cet algorithme était sur le point un facteur 3 trop lent pour qu'Allen s'intègre dans les serveurs qui reçoivent les données. Les développeurs Allen avaient besoin pour apprendre à débloquer la pleine puissance de traitement des GPU pour trouver les particules chargées produites dans les collisions proton-proton à 40 MHz, écrivez des versions de GPU du reste des dizaines d'algorithmes de reconstruction et de sélection utilisés dans le déclencheur de premier niveau de LHCb, et effectuer un test d'intégration pour démontrer comment le système fonctionnerait pendant la prise des vrais données.

Au cours des deux dernières années, l'équipe Allen a fait exactement cela. Une percée cruciale a été le développement d'un gestionnaire de mémoire personnalisé et d'un programmateur d'algorithmes par Daniel Cámpora, un doctorant co-supervisé par le CERN et l'Université de Séville qui a codirigé l'effort Allen avec Dorothea et Roel Aaij, un ingénieur logiciel de NIKHEF. Cela a transformé Allen d'une collection d'algorithmes rapides en un cadre flexible capable de répondre la variété complète des cas d'utilisation qui existent dans un véritable système de déclenchement de premier niveau. Ce qui a commencé comme un projet "pour voir ce qui était possible" s'est donc rapidement transformé en une véritable option à considérer pour la collaboration. Les développeurs du déclencheur de premier niveau basé sur le processeur de base ont également fait des progrès majeurs au cours de cette période, atteignant un gain de vitesse de traitement supérieur à 4. Les chercheurs du projet RECEPT ont également joué un rôle important dans ce travail. Renato a dirigé les premières optimisations de la reconstruction CPU du détecteur de vertex avant Arthur Hennequin, un étudiant en master dans notre équipe en 2018 co-encadré avec l'équipe ALSOC du laboratoire LIP6, fait une percée cruciale avec une reconstruction CPU parallèle au maximum et optimisée pour les architectures SIMD modernes en 2019. Lorsque Allen a réussi son test d'intégration en janvier 2020, LHCb était donc dans l'enviable position de choisir entre deux solutions technologiques exceptionnellement optimisées.

En fin de compte, le choix était basé non seulement sur les avantages de coûts d'Allen pour Run 3, mais sur la volonté de capitaliser et de s'appuyer sur les connaissances du traitement GPU qui s'étaient développées au sein de la collaboration. Avec le traitement des données commerciales de plus en plus réalisé par des mélanges hétérogènes de processeurs CPU, GPU et FPGA, Allen offre au LHCb à la fois un système performant pour Run 3 et la possibilité de garder une longueur d'avance sur la technologie et profiter au maximum des développements futurs de l'industrie. Et les progrès réalisés dans la vitesse de traitement du CPU ne seront pas gaspillés mais vont etre cruciales pour rendre le processeur de deuxième niveau de LHCb plus performant et donc fournir plus de physique pour les analyses de la collaboration - le meilleur des deux mondes!

En savoir plus sur Allen consulter le TDR et notre papier publié dans le journal Computing and Software For Big Science.

-- V.V.G., 3 juin 2020

Today the LHCb collaboration presented a technical design report for a new first level trigger based on graphics processors (GPUs) to the CERN LHC Experiments Committee (LHCC), and announced its decision to use this system as its new baseline in Run 3 of the LHC, due to start sometime in 2021 COVID permitting. This new system, named "Allen" after the pioneering computer scientist Frances E. Allen, will be the first complete high-throughput GPU based trigger deployed at a High Energy Physics (HEP) experiment, processing 40 MHz of LHC collisions and reducing their rate by between a factor 30 and 60. The RECEPT team played a key role in proposing and delivering Allen, with Dorothea co-leading the development and Renato and Florian making crucial contributions to the charged particle reconstruction and pp collision finding, respectively. So how did it come together?

The upgraded LHCb experiment, due to start taking data in 2021, must process 5 TBytes of data per second and select the most interesting 10 Gigabytes for permanent storage and physics analysis, permanently discarding the rest in a real-time processing system called the trigger. At the heart of the Allen proposal was the realization that modern GPUs had become powerful enough that the entire first level trigger of LHCb could be implemented with around 500 such GPU cards. This compact implementation, illustrated below, allows the first level trigger to be deployed directly in the "EB" servers which receive the data from the detector. These servers would normally house dedicated high-bandwidth network cards to send the detector data onwards for processing, but because Allen can process the data in place, the GPUs can replace these network cards. This means that there are no cost overheads associated with deploying the GPUs, and on the contrary they save the money which would have been spent on network cards. Depending on the market, the overall system cost might be zero or even negative.

Allen was of course not developed ex nihilo: many LHCb groups had carried out R&D into the feasibility of GPU processing algorithms since around 2013. But at the moment when Allen was proposed in February 2018, the only part of the first-level trigger which existed on GPUs was the reconstruction of LHCb's vertex detector. And even that algorithm was about a factor 3 too slow for Allen to fit in the servers which receive the data. The Allen developers needed to both learn how to unlock the full processing power of GPUs to find the charged particles produced in proton-proton collisions at 40 MHz, write GPU versions of the rest of the dozens of reconstruction and selection algorithms used in LHCb's first level trigger, and perform an integration test to demonstrate how the system would work in production.

Over the past two years the Allen team did just that. A crucial breakthrough was the development of a custom memory manager and algorithm scheduler by Daniel Cámpora, a PhD student co-supervised by CERN and the University of Sevilla who co-led the Allen effort with Dorothea and Roel Aaij, a software engineer from NIKHEF. This transformed Allen from a collection of fast algorithms into a flexible framework capable of addressing the full variety of use cases which exist in a real first level trigger. What started as a blue skies project "to see what was possible" therefore rapidly transformed into a genuine option for the collaboration to consider. The developers of the baseline CPU-based first level trigger also made major advances over this period, achieving a more than factor 4 gain in processing speed. RECEPT researchers played important roles in that work as well. Renato led the early optimizations of the CPU vertex detector reconstruction before Arthur Hennequin, a master's student in our team in 2018 co-supervised with the ALSOC team of the LIP6 laboratory, made a crucial breakthrough with a fully parallel CPU vertex detector reconstruction optimized for modern SIMD architectures in 2019. When Allen passed its integration test in January 2020, LHCb was therefore in the enviable position to choose between two exceptionaly optimized technological solutions.

In the end, the choice was based not only on Allen's cost benefits for Run 3, but on the desire to capitalise and build on the knowledge of GPU processing which had developed within the collaboration. With commercial data processing increasingly carried out by heterogeneous mixtures of CPU, GPU, and FPGA processors, Allen offers LHCb both a performant system for Run 3 and the chance to stay ahead of the technology curve and maximally benefit from future industry developments. And the advances made in CPU processing speed will not be wasted but pay off in making LHCb's second-level CPU trigger more performant and hence deliver more physics for the collaboration's analyses -- the best of both worlds!

Read more about Allen in our TDR and paper published in Computing and Software For Big Science.

-- V.V.G., 3 June 2020

Članovi LHCb eksperimenta su danas predali izveštaj o tehničkom projektu novog “trigger” sistema za obradu podataka u realnom vremenu na bazi grafickih (GPU) kartica CERN-ovom komitetu za LHC eksperimente (LHCC). Ovaj sistem, nazvan “Allen” po čuvenoj informatičarki Frances E. Allen će biti prvi velikoprohodni trigger sistem jednog eksperimenta fizike visokih energija (HEP), kompletno izvršen GPU karticama. Kada bude pušten u rad 2021. godine (ako to COVID dozvoli), Allen će obradjivati svih 40 MHz protonskih sudara u LHCb-u, i izabrati izmedju jedan i po i tri posto najinteresantnijih za dalju obradu i analizu, a odbaciti ostale. Istraživači projekta RECEPT su igrali ključnu ulogu u koncepciji i i izradi Allen-a: Dorothea je od početka bila jedna od vodja projekta, dok su Renato i Florian dali značajne doprinose u rekonstrukciji putanja nabijenih čestica i preciznom pronalaženju mesta sudara LHC-vih protona. Kako se sve to odigralo?

Unapredjeni LHCb eksperiment, koji će početi sa radom 2021. godine, mora obradjivati 5 Terabajta podataka u sekundi i od njih izabrati 10 Gigabajta najinteresantnijih za trajno čuvanje i dalju analizu, a ostatak trajno odbaciti. Ova obrada podataka u realnom vremenu se odvaja u sistemu kompjuterskih procesora koji zovemo “trigger”. Tokom poslednjih godina moderni grafički procesori su postali dovoljno moćni da je postalo moguće sprovesti ceo prvi nivo tog trigger sistema na otprilike 500 takvih GPU kartica. Tako kompaktan dizajn, čija se šematika nalazi na dnu teksta, dozvoljava ovom trigger-u prvog nivoa da bude postavljen direktno u “EB” kompjuterske servere koji primaju podatke od detektora LHCb. Bez Allen-a ti serveri bi bili popunjeni visokoprohodnim mrežnim karticama koje bi podatke slale u druge servere gde bi bili obradjivani; medjutim Allen dozvoljava direktnu zamenu tih mrežnih kartica za GPU kartice koje onda obradjuju podatke na mestu. Samim time ne samo da nema dodatnih troškova vezanih za korišćenje grafičkih kartica, već, u zavisnosti od tržišnih cena, one mogu čak koštati i manje od novca koji će LHCb uštedeti time što ne mora da kupi mrežne kartice.

Allen nije, naravno, razvijen ex nihilo. Mnoge LHCb grupe su istraživale mogućnost korišćenja grafičkih kartice za obradu podataka još od 2013. godine. Ali u trenutku kad je Allen predložen u februaru 2018. godine, jedini deo trigger-a prvog nivoa koji je mogao biti izveden na GPU karticama je bila rekonstrukcija LHCb-ovog takozvanog “vertex” detektora. A čak i taj algoritam je bio otprilike tri puta prespor za brzinu koja je bila neophodna ne bi li Allen mogao biti sproveden sa 500 kartica. Ekipa programera je, dakle, morala istovremeno da nauči kako da iskoristi punu teoretsku moć GPU kartica za pronalaženje putanja čestica u detektoru, da napiše par desetina različitih algoritama za rekonstrukciju tih putanja u različitim delovima detektora i izbor najinteresantnijih, i da pokaže u realnim uslovima kako će Allen primati i obradjivati podatke u pravom detektoru a ne samo simulaciji.

Tokom zadnje dve godine ekipa Allen-ovih programera je uspešno izvršila baš taj zadatak. Jedan od ključnih doprinosa je doneo Daniel Cámpora, doktorant CERN-a i Univerziteta Sevilje, koji je vodio projekat zajedno sa Dorotheom i Roel Aaijom, softverskim inžinjerom iz NIKHEF-a. Daniel je razvio posebno prilagodjeni program za upravljanje i raspodelu memorije GPU kartice, kao i rasporedjivanje samih algoritama, čime je Allen postao ne samo skup brzih pojedinačnih algoritama već istinsiki fleksibilan sistem sa svim sposobnostima jednog trigger-a prvog nivoa. Tako je ovaj projekat, koji smo počeli onako da vidimo šta mož da bidne, polagano postao realna opcija za LHCb. U isto vreme programeri baznog CPU trigger sistema su takodje napravili ogrome korake unapred, i uspeli da svoj sistem ubrzaju za čak faktor četri! Istraživači iz tima RECEPT su igrali važne uloge i u tom radu. Renato je vodio prvu optimizaciju rekonstrukcije vertex detektora, a onda je Arthur Hennequin, master student u našoj ekipi i ekipi ALSOC LIP6 laboratorije 2018, napisao maksimalno paralelnu verziju tog algoritma optimiziranu za moderne SIMD arhitekture 2019. godine. Kada je Allen uspešno pokazao rad u realnim okolnostima Januara 2020, LHCb je morao birati izmedju dva sjajna i visoko performantna sistema.

Na kraju, izbor LHCb eksperimenta nije zasnovan samo na uštedi novca koji Allen omogućava, već i na želji da iskoristi i dalje utemelji znanje o GPU programiranju koje je razvijeno medju LHCb istraživačima tokom ovog rada. To znanje može biti od posebne vrednosti za buduća unapredjenja eksperimenta, pošto komercijalni sistemi za obradu velikih količina podataka sve više koriste upravo mešavine GPU, CPU, i FPGA procesora. Vidjen u tom okviru, Allen LHCb-u nudi sa jedne strane visoko performantan i jeftin sistem za sledeću fazu eksperimenta, kao i šansu da ostane ispred razvoja tehnologije u industriji i samim time da od tih razvoja maksimalno profitira u budćnosti. A veliki napredci koji su ostvareni u brzini CPU obrade podataka neće biti bačeni u vodu — naprotiv. Oni će omogućiti slična ubrzanja u CPU trigger-u drugog nivoa, i samim time omogućiti LHCb-u da prikupi više interesantnih podataka za analize. Drugim rečima imaćemo najbolje aspekte oba sistema.

Za dublji uvid u arhitekturu i sposobnosti sistema Allen, pročitajte naš TDR dokument i rad u žurnalu Computing and Software For Big Science.

-- V.V.G., 3 juni 2020

Le projet RECEPT porte sur des études de précision mettant à l’épreuve le Modèle standard de la physique des particules avec l’expérience LHCb au Cern. Depuis sa formulation dans les années 70, le Modèle standard de la physique des particules s’est avéré une description particulièrement réussie et prédictive de notre monde aux échelles subatomiques. Il permet de décrire la matière qui nous entoure en deux familles de six quarks et six leptons ainsi que leurs interactions en quatre bosons. À cela s’ajoute le boson BEH (Brout-Englert-Higgs), récemment découvert au LHC. Néanmoins, le Modèle standard est en contradiction fondamentale avec des théories non moins solides qui décrivent l'Univers. Par exemple, quand nous observons étoiles et galaxies, nous pouvons estimer leur masse de deux manières : en mesurant la quantité et le type de lumière qu'ils émettent ou en comparant leurs mouvements aux équations de la relativité générale. Le désaccord flagrant entre ces deux méthodes a permis de conclure à l'existence de "matière noire" non prévue par le Modèle standard des particules. Pour cette raison et d'autres contradictions, les physicien.ne.s estiment que le Modèle standard est inachevé et qu'une théorie plus fondamentale est nécessaire.

Afin d'apercevoir des signes d’une théorie plus fondamentale au-delà du Modèle standard, il est crucial d'en examiner les prédictions avec une précision toujours plus élevée. Parmi elles, "l’universalité leptonique" prévoit que les électrons, muons et taus, tous membres de la famille des leptons, doivent se comporter de la même manière et être produits en égale quantité lors de désintégrations. Le projet RECEPT va utiliser les données de l'expérience LHCb, basée au Grand collisionneur de hadrons (LHC) au Cern, en collaboration avec 69 instituts dans 16 pays. Pendant la première phase du projet, les chercheur.e.s analyseront les désintégrations de particules contenant un quark beau (b). En outre, les scientifiques du projet RECEPT joueront un rôle essentiel dans l’amélioration du détecteur de LHCb prévue pour la phase 2 du LHC, appelée "LHC haute luminosité", qui multipliera par 100 le volume des données. Compte-tenu de la taille des données à analyser et surtout à stocker, les chercheur.e.s développeront dans un deuxième temps un système permettant une analyse en temps réel. Cela leur permettra alors d’étudier les désintégrations des particules contenant un quark étrange (s). Les deux phases du projet RECEPT fourniront les mesures les plus précises jamais réalisées de l'universalité leptonique, ouvrant ainsi une fenêtre sur la physique au-delà du Modèle standard.

Le projet RECEPT est financé par l'Union Europeene dans le cadre de programme H2020 de Conseil Europeen de Recherche (ERC), dans le cadre de "grant agreement" numero 724777.

The Standard Model of particle physics is a remarkably successful and economical description of nature at microscopic scales. Six quarks, six leptons, four force carriers and the Higgs boson are all that makes up the Standard Model, some of whose predictions have been verified to better than one part in a billion. Nevertheless, the Standard Model is in fundamental contradiction with equally successful theories of the macroscopic universe. For example, when we observe stars and galaxies, we can estimate their mass in two ways : by measuring the amount and type of light which they emit, and by comparing their motions to the equations of General Relativity. When we do so, we find a significant disagreement in the two methods, indicating the existence of other “dark” matter not predicted in the Standard Model. Because of this and other contradictions, physicists believe that the Standard Model is incomplete, and that a more fundamental theory is needed.

In order to glimpse the more fundamental theory beyond the Standard Model, it is crucial to test the Standard Model’s predictions with ever higher precision. One of the most precise predictions is called “lepton universality” : that the six leptons couple with equal strength to the force carriers (photon and the W/Z bosons) of the electroweak force. RECEPT will use the LHCb experiment, based at the Large Hadron Collider at CERN, to make the world’s most precise tests of lepton universality in collaboration with 69 institutes across 16 countries. In the first phase of RECEPT, data collected with the existing LHCb detector will be used to measure lepton universality in the decays of particles containing a “bottom” quark. In addition, RECEPT’s researchers will play a crucial role in the upgrade of the LHCb detector, which will increase the data volume 100 times. Because this volume of data cannot be saved to disk, RECEPT’s researchers will develop a system allowing it to be analyzed in real-time, allowing the second phase of RECEPT to measure lepton universality in the decays of particles containing a “strange” quark. Together, the two phases of RECEPT will deliver the most precise measurements of lepton universality anywhere, either opening a window to physics beyond the Standard Model or else tightly limiting its properties.

The RECEPT project is financed by the European Research Council (ERC) under the European Union's Horizon 2020 research and innovation programme under grant agreement No. 724777.

Standardni model fizike čestica je veoma uspešan i sažet opis prirode na mikroskopskim razmerama. Šest kvarkova, šest leptona, četiri nosioca sila i Higsov bozon opisuju u standardnom modelu ceo mikroskopski svet, a neka predvidjanja ovog modela su u opitima potrvdjena sa preciznošću od jednog milijarditog dela. Uprkos tome, standardni model u osnovi protivreči jednako uspešnim teorijama makroskopskog sveta. Na primer, kada posmatramo zvezde i sazveždja, možemo na dva načina utvrditi njihovu težinu: ili merenjem količine i boje svetlosti koju one zrače, ili uporedjivanjem njihovih putanja sa predvidjanjima teorije generalnog relativiteta. Medjutim, kada ta dva merenja težine uporedimo, ona se ne slažu! To nam ukazuje na protivrečnost standardnog modela i teorije generalnog relativiteta, iz čega fizičari najčešće zaključuju da standardni model nije kompletna teorija mikroskopskog sveta i da je treba dopuniti dodatnim česticama ili nosiocima dodatnih sila, na primer takozvanom “tamnom materijom”, koja bi trebalo da objasni opaženo pomeranje nebeskih tela.

Da bismo stekli uvid u tu opširniju odnosno fundamentalniju teoriju koja leži dalje od standardnog modela, važno je dalje ispitivati njegova predvidjanja. Jedno od najosnovnijih predvidjanja standardnog modela jeste takozvana “univerzalnost leptona”: da se šest leptona tog modela jednakom snagom vezuju za nosioce elektroslabe sile. Projekat RECEPT će koristiti detektor LHCb, koji je stvoren u saradnji 69 instituta nauka iz 16 zemalja sveta i čini jedan od četiri glavna eksperimenta vezana za takozvani “veliki sudarač hadrona” u CERN-u, sa ciljem da izvrši najpreciznija ispitivanja univerzalnosti leptona. U prvoj fazi projekta, podaci prikupljeni sa postojećim LHCb detektorom će biti iskorišćeni za ispitivanje univerzalnosti leptona u raspadu mezona koji u svome sastavu imaju takozvani “bottom” kvark. Istovremeno, RECEPT-ovi istraživači će razviti i unaprediti sistem obrade podataka LHCb eksperimenta, koji će nam omogućiti da obradimo 100 puta više podataka u sekundi i da, u drugoj fazi projekta, izmerimo i univerzalnosti leptona u raspadu mezona, koji u svome sastavu imaju takozvani “strange” kvark. Ove dve faze RECEPT-a će nam omogućiti da ostvarimo najpreciznija merenja univerzalnosti leptona na svetu, i da možda sagledamo prve nagoveštaje neke nove fizike na ivicama maglovitog pejzaža standardnog modela.

Projekat RECEPT finansira Evropska zajednica u okviru programa H2020 Evropskog naučnog veća (ERC), broj projekta 724777.

Vladimir Vava Gligorov (PI) : I spent my student years being bothered by quantum nonlocality, but eventually discovered that not being able to do maths would prove less of a problem if I became an experimental physicist. Now I divide my time between thinking about the myriad contradictions in our theories of the microscopic and macroscopic universe, and building real-time analysis systems to help LHCb probe these contradictions to ever higher precisions. I am also involved in the International Masterclass programme and regularly work with students at the Petnica Science Centre, trying to make the next generation as excited about fundamental science as I am. Life is too short for most social media, but I do tweet @particleist --- not necessarily about science.

Renato Quagliani : I am a postdoc researcher from Italy. I got a double PhD degree from Bristol University and Paris Sud University and during that time I spent most of my time surfing through the LHCb software, rewriting, debugging and optimising the track reconstruction for the LHCb upgrade as well as analysing data produced by the LHCb experiment. All experimental physicists aim at working on searches of New Physics and place the bricks to allow theorists and experimentalist to move the mankind's knowledge one step further. This is what RECEPT does and why I am happy to be part of it.

Christina Agapopoulou : I am a postdoc researcher from Greece. I came to France for my master, where I joined the ATLAS group of IJCLab to explore novel particle detection techniques using precise timing information. I continued along the same path for my PhD in Université Paris-Saclay, where I got involved in the development of the High Granularity Timing Detector Upgrade of ATLAS for the HL-LHC era. In parallel, I participated in a search for supersymmetry in hadronic final states with the Run 2 data of ATLAS. The search for new physics and the development of innovative detection techniques are at the heart of my scientific interests. As a postdoc in the RECEPT project, I am excited to continue searching for new physics emerging in lepton flavour universality observables, as well as work on the GPU-based full-software trigger upgrade of LHCb.

Marianna Fontana : Marianna Fontana's research activities focus on the search for New Physics effects in the flavour physics sector. She studies rare decays of mesons containing charm quarks and she contributes to the developments of the GPU-based hight level trigger software for the upcoming LHCb upgrade.

Sevda Esen : I am a postdoctoral researcher from Turkey. I worked on Belle experiment for my PhD before joining LHCb experiment. For both experiments, my main work has been on the understanding properties of Bs mixing and CP violation. I also worked on the simulation and software development for the upgraded downstream tracking detector at LHCb, famously known as SciFi (Scintillating Fiber Tracker). For this year, I will be doing more software development to get ready for data taking in early 2022!

Lukas Calefice : I’m part of a joint PhD project between TU Dortmund and Sorbonne Université/LPNHE. I am part of the LHCb experiment since my bachelor project and have worked on limit setting methods and radiative charm meson decays. My current research focuses on Early Measurements in the Run 3 of the LHC for validating the upgraded LHCb detector and preparing it for another successful period of measurements in the field of flavour physics. For this I’m investigating production cross-sections of weakly decaying strange hadrons. Moreover, I am involved in the implementation of the hybrid seeding algorithm within the Allen project that will pave the way for a downstream tracking in the first stage of the upgraded LHCb trigger system. Apart from this, I am studying the prospects for measurements with rare kaon decays in Run 3.

Alessandro Scarabotto I’m Alessandro Scarabotto, Italian PhD student at LPNHE working for LHCb on Rare Charm physics and on the new Trigger Upgrade. I started my physics career in Ferrara (Italy) where I followed my bachelor and master degrees. I had the chance to spend one year in US (Old Dominion University) and one year in France (Université Paris Sud). Outside physics in my free time, I love to play volleyball and travel.

Florian Reiss : I'm a PhD student from Germany. Before coming to Paris I studied in Heidelberg. During my Bachelor thesis I worked in the Mu3e group looking for decays violating lepton number conservation. For my Master thesis I joined the LHCb collaboration, where I contributed to the spectroscopy subgroup. After graduating in 2017 I became a member of the LHCb group at the LPNHE to work on tests of lepton universality. Florian defended his thesis in December 2020 and has just started as a postdoc in the University of Manchester LHCb group

Da Yu Tou : Hi, I am a doctoral student from Malaysia who graduated with Master of Physics degree from University of Manchester in 2017. My current physics interest is in test of lepton non-universality, specifically in B->K*ll. Also, I am looking into using GPU computing and neural networks to improve the performance of event reconstruction software in LHCb. My list of publication and presentation is empty but I will have a few in 3 years. Stay tuned! Da Yu defended his thesis in December 2020.

Dorothea vom Bruch I first got interested in lepton universality during my Master's degree at UBC and TRIUMF in Vancouver, studying the decay ratio of pions to electrons and muons. Staying in the field of lepton physics, I continued with a PhD in Heidelberg and Mainz working on the Mu3e experiment, which is aimed to search for lepton flavour violation. I was mainly involved in developing and implementing an online signal selection process on GPUs to reduce the data rate of the experiment, and in characterizing a prototype of the high-voltage monolithic active pixel sensors envisaged for the spectrometer. Still being enthusiastic about lepton flavour, I am now part of the RECEPT project as a postdoc, working on track reconstruction on GPUs and studying lepton universality. Following her successful leadership of the Allen project, Dorothea obtained a permanent CNRS position in the LHCb group at CPPM in the 2020 concours.

See full archive of papers, presentations, and proceedings

See full archive of pedagogical resources